La supervisione clinica dell’algoritmo di IA ne riduce la dipendenza dallo stesso

I Cardiologi che non sono in grado di comprendere il funzionamento interno del modello non saranno in grado di spiegare il processo di trattamento medico ai loro pazienti

Fiducia del paziente e del clinico

Un’assistenza sanitaria efficace si basa sul mantenimento di una fiducia sostanziale tra il pubblico e le professioni e i sistemi sanitari1. Gli organismi professionali di tutto il mondo insistono giustamente sul fatto che i Cardiologi hanno il dovere etico di salvaguardare e promuovere la fiducia dei pazienti. Ciò comprende la fiducia negli strumenti clinici che scelgono di utilizzare e nella selezione di tali strumenti, compresi gli strumenti basati sull’intelligenza artificiale. Gli algoritmi di deep learning perfezionano continuamente i loro parametri ed evolvono le regole. Ciò può portare a processi decisionali opachi, nascosti anche agli sviluppatori, una situazione nota come problema della scatola nera2. Questa situazione può essere evitata proponendo una convalida degli output dei modelli di IA da parte del Cardiologo, garantendo così la sicurezza in situazioni di input insolite e eliminando i pregiudizi nei dati.

Aspetti regolatori

Il software di IA o i dispositivi medici potenziati dal software di intelligenza artificiale hanno la capacità di apprendere automaticamente dall’uso nel mondo reale e possono quindi migliorare le prestazioni nel tempo. Questo distingue il software da altri software utilizzati nell’assistenza sanitaria e presenta nuove sfide normative. Algoritmi che sono inspiegabili nel loro processo decisionale, tendono a cambiare continuamente con l’uso e l’aggiornamento automatico, forse con caratteristiche che vanno oltre gli studi clinici inizialmente approvati e per questo motivo è auspicabile che vengano ultimate politiche e linee guida speciali che uniformino standard normativi e valutino l’impatto algoritmico dell’IA2. Anche le questioni di responsabilità hanno necessità di essere affrontate e normate: ad esempio, c’è la questione di chi sia responsabile quando gli errori derivano dall’uso di software di intelligenza artificiale o dispositivi potenziati dall’intelligenza artificiale nel contesto clinico. Le attuali linee guida medico-legali, in tutto il mondo, non sono chiare su dove iniziano o finiscono le linee di responsabilità quando gli agenti di IA guidano l’assistenza clinica come ad es. sulle implicazioni per la negligenza medica nel contesto della diagnostica dominante guidata dall’IA3.

Implicazioni dell’utilizzo di IA nell’healthcare

L’uso clinico dei modelli di IA trasformerà sicuramente gli attuali modelli di erogazione dell’assistenza sanitaria; in effetti, la loro portata si estenderà oltre le impostazioni cliniche. L’IA ha la capacità di superare i limiti con i tradizionali sistemi di supporto alle decisioni cliniche basati su regole e di consentire un migliore supporto diagnostico e decisionale4. Anche le opportunità di automatizzare il triage e lo screening e somministrare il trattamento stanno diventando una realtà. L’intelligenza artificiale integrata nei dispositivi medici, supportata dall’Internet delle cose e dal Wi-Fi veloce, potrebbe portare i servizi sanitari abilitati nelle case dei pazienti, democratizzando così l’assistenza sanitaria.

Modelli di governance

Per affrontare i suddetti problemi etici, normativi e di sicurezza e qualità, tra i vari modelli di governance per l’applicazione dell’IA nell’assistenza sanitaria è necessario tenere in considerazioni quattro componenti principali: l’equità, la trasparenza, l’affidabilità e la responsabilità.

- Equità

I dati nel contesto sanitario possono includere (ma non essere limitati a) immagini mediche, testo dalle cartelle cliniche dei pazienti, diagnosi, trattamento e codici di rimborso2. È auspicabile avere un pannello di governance dei dati costituito dagli sviluppatori di IA e che includa rappresentanti di pazienti e gruppi target, esperti clinici e persone con competenze IA, etiche e legali pertinenti. Il gruppo esaminerà i set di dati utilizzati per l’addestramento dell’IA per garantire che i dati siano rappresentativi e sufficienti per informare i risultati del modello richiesti. Il principio di giustizia comprende l’equità nell’accesso all’assistenza sanitaria. Di conseguenza, le applicazioni di IA non dovrebbero portare a, o esacerbare, discriminazione, disparità o disuguaglianze sanitarie.

- Trasparenza e Autonomia

Una trasparenza limitata può ridurre l’affidabilità dei modelli di IA nell’assistenza sanitaria compromettendo potenzialmente anche la convalida delle raccomandazioni cliniche del modello e l’identificazione di eventuali errori o pregiudizi5. Modelli sviluppati di deep learning nell’ambito dell’imaging cardiologico oltre che nella previsione del rischio clinico sono stati eccezionalmente promettenti ma al tempo stesso possono risultare difficili da spiegare. Per affrontare questo problema a livello generale, è emerso un campo definito “IA spiegabile (XAI)”6. L’intenzione della XAI è quella di consentire un insieme di tecniche che permettano la spiegabilità dei modelli algoritmici pur mantenendo prestazioni elevate. Sufficiente trasparenza e spiegabilità è richiesta dal classico principio etico del rispetto dell’autonomia7. Gli agenti di IA devono quindi sostenere, piuttosto che diminuire, la fornitura di un livello di comprensione trasparente e sufficiente a soddisfare le esigenze individuali dei pazienti per il processo decisionale. Devono anche consentire ai pazienti la libertà di prendere decisioni relative alla salute senza coercizione o pressioni indebite.

- Affidabilità

È importante che i medici comprendano la causalità delle condizioni mediche e, nel caso dell’IA, i metodi e i modelli utilizzati per supportare il processo decisionale clinico8. Inoltre, i recenti episodi di Ospedali che condividono i dati dei pazienti con gli sviluppatori di IA senza il consenso informato dei pazienti hanno aggiunto il problema della fiducia verso gli sviluppatori di IA e verso l’IA stessa9. Per affrontare questi problemi, è proponibile, secondo una modello trasparente di governance clinica, un approccio su più fronti che include l’istruzione tecnica, l’alfabetizzazione sanitaria, il pieno consenso informato e gli audit clinici. Sono note raccomandazioni e iniziative per educare gli operatori sanitari sulle basi dell’IA (cioè tecniche, applicazione e impatto)10. Riteniamo che queste iniziative siano un elemento vitale per costruire la fiducia per l’IA tra gli operatori sanitari. Comprendendo come funziona l’IA e quali vantaggi e limitazioni ha nell’erogazione dell’assistenza sanitaria, i medici molto probabilmente accetteranno di più l’IA. Inoltre, l’educazione dovrebbe estendersi alla comunità dei pazienti e al pubblico. Per consentire tale formazione (sia degli operatori sanitari che della comunità dei pazienti), ad es. è raccomandabile costruire partenariati tra istituzioni accademiche e servizi sanitari, garantendo in tal modo un uso complementare delle competenze nella tecnologia dell’IA, nella pedagogia, nella politica sanitaria e nella pratica clinica. Il contenuto educativo di base può essere riproposto per soddisfare diversi tipi di pubblico e adattandolo all’evoluzione della tecnologia AI e alla sua applicazione. Le politiche e le linee guida istituzionali potranno essere rielaborate per garantire che i pazienti siano consapevoli che il medico curante sta traendo supporto dalle applicazioni di IA, quali sono i limiti delle applicazioni e che i pazienti sono in grado, se del caso, di rifiutare il trattamento che coinvolge l’IA. Quando i dati dei pazienti sono condivisi con gli sviluppatori di IA, deve esserci un processo per ottenere il consenso pienamente informato dei pazienti e i dati resi anonimi in misura tale che i dettagli dei singoli pazienti non possono essere riconosciuti dagli sviluppatori11. Le autorizzazioni a fornire dati dovrebbero essere revocabili. Inoltre, dovrebbe essere presa in considerazione la privacy differenziale, una soluzione tecnologica che riduce al minimo i rischi di analisi di dati riservati e sensibili. Attraverso questo approccio, si ottiene un elevato livello di anonimizzazione dei dati riducendo i rischi associati alla reidentificazione, tutelando così la privacy dei pazienti. Inoltre, raccomandiamo, ove possibile, l’uso di set di dati pubblici per sviluppare software di intelligenza artificiale per ridurre al minimo le violazioni della privacy. Dovrebbero esserci chiari obiettivi clinici associati alle applicazioni di IA e la veridicità delle affermazioni fatte dagli sviluppatori di IA dovrebbe essere testata.

- Responsabilità

La responsabilità, la componente più importante della governance da implementare, inizia con lo sviluppo del modello di IA e si estende fino al punto in cui il modello viene applicato nell’assistenza clinica e infine ritirato. Questo spettro coinvolge un certo numero di attori tra cui sviluppatori di software, agenzie governative, servizi sanitari, organismi professionali medici e gruppi di interesse dei pazienti. Si consiglia di identificare le fasi appropriate per le quali il monitoraggio e la valutazione sono fondamentali nel garantire la sicurezza e la qualità dei servizi abilitati all’IA. Queste fasi includono l’approvazione, l’introduzione e la distribuzione.

Fase di approvazione

Per la fase di approvazione, che copre l’autorizzazione per la commercializzazione e l’uso dell’IA nella fornitura di assistenza sanitaria, gli enti governativi o le autorità di regolamentazione hanno un ruolo importante. Negli Stati Uniti, la Food and Drug Administration (FDA) ha introdotto misure per approvare il software per uso medico12. La FDA definisce tale come sofware come dispositivo medico (SaMD). Nell’ambito della categorizzazione del rischio SaMD e dell’approvazione precommercializzazione, diversi SaMD basati sull’intelligenza artificiale sono stati approvati per l’uso nella fornitura di assistenza sanitaria. Oltre all’attuale processo di revisione del rischio e di approvazione precommercializzazione del SaMD basato sull’IA, la FDA e l’organismo regolatorio europeo MDR stanno predisponendo un “piano di controllo delle modifiche predeterminato” per anticipare i cambiamenti nell’algoritmo di intelligenza artificiale dopo l’introduzione sul mercato. Ciò significa che quando il software di IA ha un farmaco significativo che influisce sulla sicurezza o sull’efficacia, lo sviluppatore dovrebbe tornare agli organismi regolatori per la revisione e l’approvazione.

Fase introduttiva

La fase di introduzione prevede che i servizi sanitari rivedano i prodotti di IA sul mercato, li valutino per la loro idoneità nella loro fornitura di assistenza sanitaria e stabiliscano politiche e procedure pertinenti per consentire l’incorporazione del software nell’assistenza clinica. I modelli di intelligenza artificiale devono essere rivisti per le loro caratteristiche di protezione dei dati, trasparenza e minimizzazione dei pregiudizi, oltre ai rischi per la sicurezza e la qualità e le protezioni contro attacchi dannosi o errori involontari2. La rapida progressione della tecnologia di IA e le varie tecniche significano che non tutti i “panel” possibili avrebbero la capacità di effettuare la valutazione dei prodotti IA da soli. È stato proposto che un sistema di benchmarking che esamini le prestazioni e la robustezza del software medico di IA sia disponibile per guidare i servizi sanitari13. Il sistema di benchmarking potrebbe essere il risultato di partenariati pubblico-privato. La piattaforma di benchmarking consentirebbe il confronto di diversi modelli di intelligenza artificiale attraverso una dashboard di metriche delle prestazioni. Queste piattaforme di benchmarking possono guidare i singoli servizi sanitari sulle loro scelte.

Fase di distribuzione

La fase di distribuzione tiene conto dei fattori di responsabilità, monitoraggio e reporting. Se ci aspettiamo che i modelli di IA incorporino principi etici, è anche pertinente valutare i modelli responsabili durante la distribuzione. L’uso dell’IA nell’assistenza clinica e le potenziali questioni di responsabilità che possono emergere sono complesse e piene di molte incertezze14. L’uso di software di intelligenza artificiale per la pratica clinica rischia di aumentare la responsabilità per i medici e i servizi sanitari. La questione di chi diventa responsabile quando sorgono problemi di sicurezza e qualità a causa dell’uso di software medici di IA richiede un’adeguata guida legale. Le attuali leggi sulla negligenza medica potrebbero non essere in grado di adattarsi a questo scenario e rimanere non testate, se non inadatte, al contesto di utilizzo di software medico autonomo o semiautonomo14. È sempre richiesto un approccio equilibrato in cui va confermata la sicurezza dei pazienti, l’autonomia dei medici e il supporto decisionale clinico derivato dai modelli di IA. Gli audit potrebbero testare la distorsione, l’accuratezza, la prevedibilità, la trasparenza del processo decisionale e il raggiungimento dei risultati clinici del modello. Il modello tipo di governance clinica GMAIH (Governance Model for the application of AI in Health care)15 suggerisce il vero processo di responsabilità e segnalazione per rispecchiare la strategia circa l’attuazione della governance clinica, che copre la composizione degli standard nazionali utilizzati dai servizi sanitari per garantire sicurezza e qualità, modelli di governance clinica più locale locale, valutazione annuale delle prestazioni del modello di IA, visite in loco, meccanismi di apprendimento tra cui la segnalazione di eventi avversi, incorporazione delle opinioni dei pazienti e istruzione e formazione di medici e pazienti16.

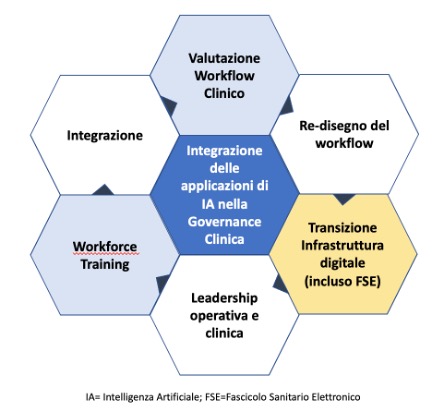

Integrazione

Mentre la discussione precedente si è concentrata sul modello di governance “per sé”, una considerazione molto importante è come un modello si integra nel flusso di lavoro clinico. Il flusso di lavoro clinico è rappresentato nelle attività di routine eseguite dai medici e nei risultati da esso generati17. Tra queste figurano compiti amministrativi quali la pianificazione e la fatturazione degli appuntamenti e compiti clinici quali le cure mediche e l’educazione dei pazienti. Per garantire che le applicazioni di intelligenza artificiale producano il valore necessario per i medici e i pazienti, esse devono essere integrate nel flusso di lavoro clinico. I passaggi per integrare l’applicazione AI sono descritti nella Figura 1. Il modello GMAIH interagisce con l’integrazione in fasi critiche garantendo che le applicazioni generino dati appropriati, che vi sia trasparenza nel processo decisionale, che le opinioni dei medici e dei pazienti siano considerate nell’integrazione e che vi sia responsabilità delle applicazioni attraverso ispezioni e rapporti. Per supportare l’integrazione e la governance, è raccomandabile che la governance sia fornita da un comitato clinico formulato con competenze ed esperienze specifiche per supervisionare l’introduzione e l’implementazione di modelli di IA nell’assistenza clinica. Un comitato di governance appropriato dovrebbe anche includere oltre i medici, manager, rappresentanti di gruppi di pazienti ed esperti tecnici ed etici in modo che si tengano deliberazioni appropriate sull’efficacia e l’efficacia dei modelli di IA oltre alla supervisione di privacy, sicurezza, qualità e fattori etici. Tale organo di governance dovrebbe inoltre garantire che sia in atto un team e un piano dotati di risorse adeguate per monitorare la deriva dei dati, la variazione inputoutput, i risultati imprevisti, il rischio di reidentificazione dei dati e gli impatti della pratica clinica. Questi sforzi dovrebbero essere segnalati e pubblicati e dovrebbe essere responsabilità della governance clinica far rispettare. Come per l’equità e la trasparenza, le componenti di governance dell’affidabilità e della responsabilità nella progettazione e nella diffusione dell’IA sono essenziali per garantire la fiducia nell’assistenza sanitaria e per salvaguardare il rapporto fiduciario tra professionisti e pazienti. Garantire che i pazienti (e il pubblico in generale) non siano danneggiati dall’IA e dall’apprendimento automatico e siano, invece, beneficiati più dalla loro presenza che dalla loro assenza, sono ragioni fondamentali per garantire l’esistenza di una governance clinica di tutti i processi di IA applicati all’assistenza sanitaria.

Bibliografia

- Char DS, Shah NH, Magnus D. Implementing machine learning in healthcare-addressing ethical challenges. N Engl J Med 2018; 378 (11): 981–3.

- Vayena E, Blasimme A, Cohen IG. Machine learning in medicine: addressing ethical challenges. PLoS Med 2018; 15 (11): e1002689.

- Reddy S, Fox J, Purohit MP. Artificial intelligence-enabled healthcare delivery. J R Soc Med 2019; 112 (1): 22–8.

- Challen R, Denny J, Pitt M, Gompels L, Edwards T, Tsaneva-Atanasova K. Artificial intelligence, bias and clinical safety. BMJ Qual Saf 2019; 28 (3): 231–7.

- Whittlestone J, Nyrup R, Alexandrova A, Dihal K, Cave S. Ethical and societal implications of algorithms, data, and artificial intelligence: a roadmap for research. 2019. http://www.nuffieldfoundation.org/sites/default/files/files/Ethical-and-Societal-Implications-of-Data-and-AI-report-Nuffield-Foundat.pdf Accessed July 1, 2019.

- Adadi A, Berrada M. Peeking inside the black-box: a survey on explainable artificial intelligence (XAI). IEEE Access 2018; 6: 52138–60.

- Gillon R. Four principles plus attention to scope. BMJ 1994; 309 (6948): 184–8.

- Holzinger A, Langs G, Denk H, Zatloukal K, Müller H. Causability and explainabilty of artificial intelligence in medicine. Data Min Knowl Discov 2019; 9 (4): e1312.

- Wakabayashi D. Google and the University of Chicago are sued over data sharing. The New York Times. June 26, 2019.

- Harvard University Laboratory of Medical Imaging and Computation. Artificial Intelligence in Healthcare Accelerated Program. 2019.

- Jones ML, Kaufman E, Edenberg E. AI and the ethics of automating consent. IEEE Secur Privacy 2018; 16 (3): 64–72.

- Food and Drug Administration. Proposed regulatory framework for modifications to artificial intelligence/ machine learning (AI/ML)-based software as a medical device (SaMD) – discussion paper. https://www.fda.gov/downloads/medicaldevices/deviceregulationandguidance/guidancedocuments/ucm514737.pdf Accessed July 1, 2019.

- Salathé M, Wiegand T, Wenzel M.. Focus Group on Artificial Intelligence for Health. Geneva, Switzerland: World Health Organization; 2018.

- Lupton M. Some ethical and legal consequences of the application of artificial intelligence in the field of medicine. Trends Med 2018; 18 (4): 100147.

- Sandeep Reddy, Sonia Allan, Simon Coghlan, Paul Cooper Journal of the American Medical Informatics Association, Volume 27, Issue 3, March 2020, Pages 491–497.

- Implementing clinical governance: turning vision into reality. BMJ 2001; 322 (7299): 1413–7.

- 2021. Ethics and governance of artificial intelligence for health. ISBN 978-92-4-002920-0 (electronic version).